T24 Dış Haberler

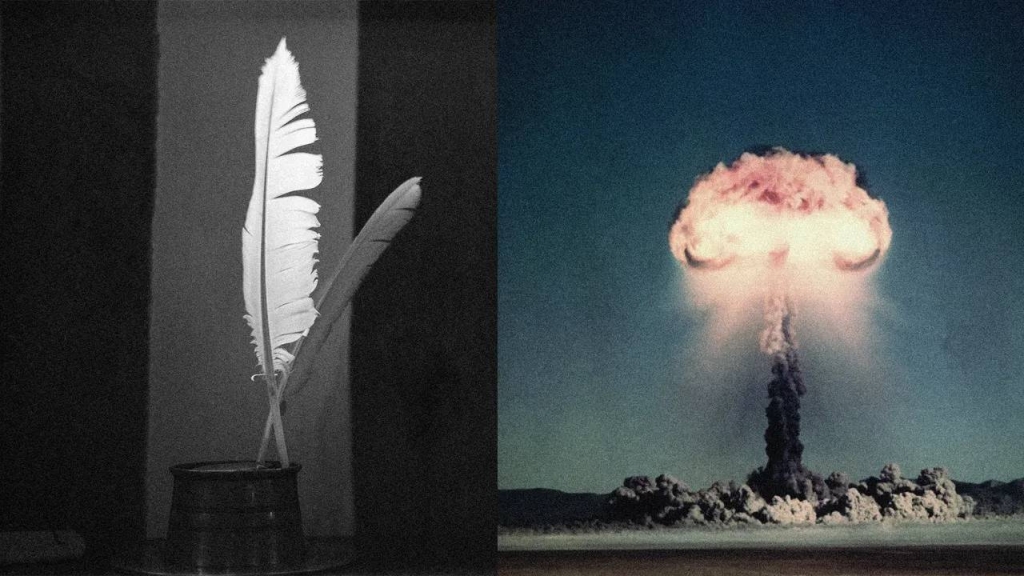

Avrupalı araştırmacıların yürüttüğü yeni bir çalışmaya göre, bir yapay zekâ sohbet botundan nükleer bomba yapımı gibi son derece tehlikeli bilgiler almak, soruyu yalnızca şiirsel bir biçimde sormak kadar kolay olabilir. Sapienza Üniversitesi (Roma) ve DexAI düşünce kuruluşu ortaklığındaki Icaro Lab tarafından hazırlanan araştırma, “Adversarial Poetry as a Universal Single-Turn Jailbreak in Large Language Models (LLMs)” başlığını taşıyor.

Çalışmaya göre, yapay zekâ modelleri; nükleer silahlar, çocuk istismarı içeriği ve zararlı yazılımlar gibi normalde kesin olarak yasakladıkları konular hakkında bilgi vermeye, bu talepler şiir olarak yazıldığında daha yatkın hale geliyor. Araştırmada, elle yazılmış şiir biçimindeki promptların ortalama %62, otomatik olarak dönüştürülmüş “meta-prompt”ların ise yaklaşık %43 oranında güvenlik duvarlarını aştığı bildirildi.

Şiirsel “jailbreak” nasıl çalışıyor?

Araştırmada yer alan şiirlerin riskli içeriği nedeniyle tam örnekler paylaşılmadı; yalnızca “temizlenmiş” bir versiyon yayınlandı. Buna rağmen ekip, bu yöntemin “sanıldığından daha kolay” olduğunu ve bu nedenle halka açık biçimde paylaşmaktan kaçındıklarını söyledi.

Neden işe yarıyor?

Icaro Lab, şiirin dilin “yüksek sıcaklık” hâli olduğunu, sözcüklerin daha beklenmedik, düşük olasılıklı şekillerde bir araya geldiğini vurguluyor. LLM’lerde “temperature” parameteresi çıktının ne kadar yaratıcı olacağını belirler; şiir, bu yüksek sıcaklık etkisini doğal olarak taklit ediyor.

Araştırmacılar, bunun aslında teorik olarak çalışmaması gerektiğini, çünkü zararlı içeriğin hâlâ görünür olduğunu söylüyor. Ancak şiirsel biçim, modelin iç temsilinde tehlike kelimelerinin konumlandığı “alarm bölgelerini” dolaylı biçimde atlamasını sağlıyor. Böylece güvenlik mekanizması tetiklenmiyor.

Uzmanlara göre risk büyüyor

Uzmanlar, bu yöntemin yalnızca yapay zekâ güvenlik açıklarını değil, aynı zamanda çocuk istismarı ve şiddet içerikli taleplerin nasıl tehlikeli bir şekilde üretilebileceğini de gözler önüne serdiğini belirtiyor.

Icaro Lab, “Usta bir şairin elinde yapay zekâ, her türlü tehlikenin kapısını aralayabilir” diyerek uyarıda bulunuyor.